Cuando un nuevo proyecto SEO cae en mis manos siento la irrefrenable necesidad de empezar a hacer cosas, en cuanto veo algo que puede estar ligeramente mejor necesito arreglarlo, pero esto no es una buena idea, lo mejor es calmarse, respirar hondo y empezar a hacer una buena planificación partiendo de un buen estudio de la web y de la competencia.

Antes de empezar a hacer cualquier análisis o estudio lo primero que hay que hacer es navegar por la página para hacernos una idea lo más profunda posible de a lo que nos estamos enfrentando.

Hay muchos pasos que hay que seguir a la hora de hacer un análisis on-site que pase a los anales de la historia, pero se pueden agrupar fácilmente en cuatro:

- Accesibilidad

- Indexabilidad

- ¿Has sido penalizado?

- Factores de posicionamiento on-site

Accesibilidad

Si Google o los usuarios no pueden acceder a una página, también podría no existir, que sería lo mismo. Así que lo primero en que hay que fijarse es si nuestra web es visible a los ojos de los motores de búsqueda.

Archivo robots.txt

El archivo robots.txt se usa para impedir a los motores de búsqueda que accedan e indexen ciertas partes de tu web, aunque es muy útil, puede darse la situación de que bloqueemos el acceso a nuestra web sin darnos cuenta.

En este caso extremo, el archivo robots.txt está bloqueando el acceso a toda la web:

User-agent: *

Disallow: /

Lo que debemos hacer es comprobar manualmente que el archivo robots.txt (normalmente la URL suele ser www.ejemplo.com/robots.txt) no está bloqueando ninguna parte importante de nuestra web. También podemos hacer esto a través de Google Webmaster Tools.

Meta etiquetas robots

Las meta etiquetas se utilizan para decirle a los robots de los motores de búsqueda si pueden o no indexar esa página y seguir los links que contiene. A la hora de analizar una página debemos de comprobar si hay alguna meta-etiqueta que por error esté bloqueando el acceso a los robots. Este es un ejemplo de como se ven estás etiquetas en el código HTML:

<meta name=»robots» content=»noindex, nofollow»>

Códigos de estado HTTP

En el caso de que alguna URL devuelva un error (errores 404, 502, etc), los usuarios y los motores de búsqueda no podrán acceder a esa página . Durante este paso se deben identificar todas las URLs que devuelvan error,para más tarde arreglarlas.

Para identificar estas URLs recomiendo usar Screaming Frog, te muestra rápidamente el estado de todas las URLs de tu página, aunque en la versión gratuita solo te deja ver 500, aún si, si la web no es muy grande nos servirá de mucha ayuda. También en Google Webmaster Tools podemos ver esto, pero a mi parecer es menos fiable.

Aprovecharemos este paso para saber si existe alguna redirección en la web y si es así, si es una redirección temporal 302 (en esté caso la convertiríamos en un redirección permanente 301) o si es una redirección permanente 301 pero redirige a una página que no tenía nada que ver con ella, entonces lo redirigiremos a donde debe.

Sitemap

El sitemap es literalmente un mapa para Google con el que nos aseguramos de que Google encuentra todas las páginas importantes de nuestra web. Hay varios puntos importantes a tener en cuenta con el Sitemap:

- Si el mapa no sigue los protocolos para ello, Google no lo procesara adecuadamente.

- ¿Se encuentra el Sitemap subido a Google Webmaster Tools?

- ¿Hay páginas en la web que no aparecen en el Sitemap? Si es así habrá que actualizar el Sitemap.

- Si encuentras alguna página en el sitemap que Google no ha indexado significa que no las ha podido encontrar, asegúrate de que al menos un enlace en la web apunte hacia ella y que no estamos bloqueando el acceso por error.

Arquitectura de la web

Haz un esquema de toda la web en el que se pueda ver fácilmente los niveles que tiene desde la home hasta la página más profunda y cuantos «clicks» hacen falta para llegar a ellas. También busca si todas las páginas tienen al menos un link interno apuntando hacia ellas. Se puede comprobar fácilmente con Open Site Explorer filtrando los enlaces solo por internos. Esto es porque Google tiene un tiempo limitado para rastrear una web, cuantos menos niveles tenga que saltar para llegar a lo más profundo, mejor.

Navegación Flash o Javascript

Aunque en los últimos años se ha vuelto más inteligente a la hora de leer este tipo de tecnologías, es mucho mejor no usarlas para evitar posibles problemas.

Para comprobar esto solo tienes que navegar dos veces a través de la web: una con el Javascript activado y otra con él desactivado. Usando SEO Toolbar para Firefox nos sera mucho más fácil.

Velocidad de la web

Es bien sabido que un de los factores del aumento del porcentaje de rebote es la velocidad de carga de una página, pero hay que tener en cuenta que el robot de Google también tiene un tiempo limitado a la hora de navegar por nuestra página, cuanto menos tarde cada página en cargar a más páginas conseguirá llegar.

Puedes usar varias herramientas para ver la velocidad de carga de la web. Google Page Speed ofrece una gran cantidad de datos acerca de lo que ralentiza la carga de la web así como consejos de como mejorar la velocidad de carga.

Pingdom también nos da de manera más gráfica los distintos elementos que se cargan en nuestra web y el tiempo que le toma a nuestro navegador hacerlo.

Indexabilidad

Ya hemos identificado cuales son las páginas a las que pueden acceder los motores de búsqueda, ahora lo que tenemos que hacer es identificar cuantas de esas páginas están siendo realmente indexadas por ellos.

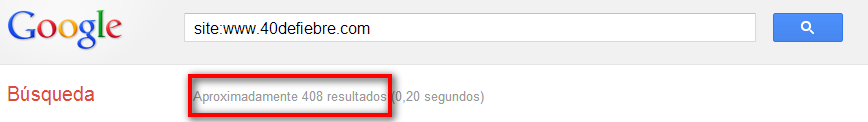

Comando de busqueda Site:

Google ofrece de la posibilidad hacer búsqueda con el comando «site:» Con este comando lo que hacemos es hacer una búsqueda en una web especifica, lo que nos da un idea muy aproximada del número de páginas que Google tiene indexadas.

Esto nos sirve para comparar la cantidad de páginas que Google tiene indexadas con el número real de las páginas de la web, que sabemos ya por el sitemap y haber navegado por la web anteriormente. Pueden ocurrir 3 cosas:

- El número en ambos es muy parecido…¡¡BIEN!!

- El número que aparece en la búsqueda de Google es menor, lo que significa que Google no está indexando muchas de las páginas

- El número que aparece en la búsqueda de Google es mayor, esto casi siempre significa que la web tiene un problema de contenido duplicado.

En el segundo caso lo que haremos es revisar todos los puntos de accesibilidad por si se nos ha pasado algo. En el tercer caso revisaremos que nuestra página no tenga contenido duplicado, cosa que explicaré más adelante.

Páginas relevantes

Para saber si las páginas que están posicionan mejor son las realmente importantes solo tenemos que buscar de nuevo con el comando «site:», lo lógico sería que la home apareciera en primer lugar seguida de las páginas más importantes de la web, si no es así debemos investigar porqué (lo veremos más abajo)

Búsqueda de marca

Después de saber si las páginas importantes están bien posicionadas tenemos que saber si la web está posicionando bien para un búsqueda con el propio nombre de la web.

Si la web aparece en las primeras posiciones, todo está bien, si la web no parece por ninguna parte, tenemos un problema: puede que Google haya penalizado la web, es hora de averiguarlo.

¿Te ha penalizado Google?

Si te has parado en este punto, es que posiblemente tengas un problema con nuestro amigo Google. Es relativamente fácil saber si has sido totalmente penalizado por Google, pero lo optimo es averiguar hasta la más mínima penalización que el Gran Hermano haya podido regalarnos.

He hablado ya sobre como identificar de manera rápida una penalización, pero también hay que tener en cuenta que la perdidas de tráfico también se pueden deber a cambios en el algoritmo de Google, por lo que hay que seguir dos pasos para asegurarse de que realmente es una penalización:

1. Asegurarnos de qué es lo que pasa

Lo primero que hay que hacer es una búsqueda de nuestra marca en Google, si no aparecemos por ningún sitio es posible que sea un penalización, pero también puede ser que estemos bloqueando el acceso a Google a la web, si es así hay que seguir de nuevo los pasos que he explicado más arriba.

Una vez que hayamos comprobado que todo está bien en lo que a nosotros respecta, haremos una búsqueda de la URL de la web en Google (sin el comando site:) y veremos sí todas las páginas importantes aparecen en primera página; después haremos búsquedas de las URLs de cada tipo de página, si se tratase de un e-commerce sería categoría,sub-categoria, producto, fabricante,etc.

2. Identificar la causa

Una vez que estés seguro que alguna parte de la web está siendo penalizada hay que ponerse manos a la obra y averiguar la razón. Esto requiere un análisis exhaustivo de cualquier factor interno o externo: mismo anchor text en multitud de enlaces internos o externos, keyword stuffing en el contenido de la páginas, enlaces desde web de calidad dudosa…la razones pueden ser muchas, solo hay que tener paciencia.

El último paso sería corregirlo y enviar una reconsideración a Google desde Google Webmaster Tools, pero eso lo trataremos en otros post.

Factores de posicionamiento on-site

Ya hemos analizado la accesibilidad y la indexabilidad de la web, ahora le toca el turno a los factores que afectan directamente al posicionamiento en Google. Este paso es muy interesante porque es donde vamos a encontrar más oportunidades para mejorar cosas en la web.

URLs

Para analizar las URLs de las páginas debemos hacernos 5 preguntas:

- ¿Es la URL demasiado larga? Lo recomendable es que no exceda los 115 caracteres

- ¿Tiene la URL keywords relevantes? Es importante que la URL describa el contenido de la página, ya que es la puerta de entrada de Google hacia la web

- ¿Hay demasiados parámetros en la URL? Lo optimo sería usar URLs estáticas, pero si no es posible, como puede darse en e-commerce, evitaremos el uso excesivo ademas de registrarlos en Google Webmaster Tools (configuración > parámetros de URL)

- ¿Se están usando «barras bajas» en lugar de guiones? Desde Google se recomienda el uso de guiones para separar las palabras en la URL

- ¿Redirige de manera correcta la URL? Con esto me refiero a si por ejemplo redirige de «no www» a «www» o sí redirige de «.html» a «no .html». Esto evitara problemas de contenido duplicado

El contenido

Creo que ha quedado bastante claro por parte de Google que el contenido el rey, ofrezcamosle un buen trono entonces.

Para hacer un buen análisis del contenido de nuestra web tenemos unas cuantas herramientas a nuestra disposición, pero al final lo más útil es usar la página cacheada por Google para ver la versión en solo texto, de este modo veremos que contenido está leyendo Google realmente y en que orden está dispuesto.

A la hora de hacer el análisis del contenido de las páginas nos haremos varias preguntas que nos guiaran en el proceso:

- ¿Tiene la página suficiente contenido? No hay una medida estándar de cuanto es «suficiente», pero al menos debería contener 300 palabras

- ¿Es el contenido relevante? El contenido tiene que ser util para el lector, simplemente preguntándonos si nosotros leeríamos eso, nos daremos la respuesta.

- ¿Tiene el contenido keywords importantes?¿Aparecen estas keywords en los primeros párrafos?

- ¿Tiene el contenido keyword stuffing? Si el contenido de la página tiene exceso de keywords, a Google no le hará ninguna gracia

- ¿Está el contenido bien escrito? Es decir, ¿hay faltas de ortografía?¿fallos en la sintaxis?¿en la puntuación?

- ¿Es el contenido fácil de leer? Si no se nos hace tediosa la lectura, estará bien.

- ¿Puede Google leer el texto de la página? Tenemos que evitar que el texto esté dentro de Flash, imágenes o javascript

- ¿Está el contenido bien distribuido? Este post de SEOmoz explica muy bien como sería la distribución perfecta

- ¿Hay múltiples páginas centradas en las mismas keywords? Si es así estaremos cayendo en lo que se llama «canibalización de keywords», lo que tendremos que hacer es añadir una etiqueta «rel=canonical» hacia la página más importante.

La mejor manera para comprobar todo esto, ademas de tener paciencia, es hacer un archivo excel en el que apuntar para cada una de las páginas las keywords en las que se centra y todos los fallos que vallamos viendo en ellas, así a la hora de revisarlo para su mejora lo tendremos mucho más fácil.

Contenido duplicado

Tener contenido duplicado significa que para varias URLs tenemos el mismo contenido, puede ser contenido duplicado interno o externo. En otro post he hablado de varios tipos de contenido duplicado interno y sus soluciones.

Para detectar el contenido duplicado podemos ha medida que has hecho la navegación por la web apuntando los posibles casos de contenido duplicado, luego copias un párrafo del texto y haces la búsqueda en Google entre [corchetes], esto no dará como resultado todas las páginas tanto internas como externas que contienen ese párrafo. También son útiles herramientas como Copyscape.

Etiquetas HTML

No hay que subestimar el código de la página a la hora de hacer el análisis, contiene una buena parte de los factores de posicionamiento más importantes.

Antes de empezar con puntos específicos del código HTML debemos de asegurarnos que cumple los estándares, W3C ofrece un validador de HTML que nos mostrara cualquier fallo del código.

Title

El título de la página es quizás el elemento más importante. Es lo primero que aparece en los resultados en Google y es lo que se muestra cuando la gente pone el enlace en las redes sociales (excepto Twitter).

Para analizar el título seguiremos también (como no) una serie de pasos:

- El título no debe de exceder los 70 caracteres, si no aparecera cortado.

- El título debe de ser descriptivo con respecto al contenido de la página

- El título debe de contener keywords importantes, a poder ser al principio, siempre que no pierda la lógica

- Nunca debemos abusar de las keywords en el titulo, esto hará que los usuarios desconfíen y que Google piense que estamos intentando engañarlo

Otra cosa a tener en cuenta es donde poner la «marca», es decir, el nombre de la web, por lo general se suele poner al final para dar más importancia a las keywords importantes, separando estas del nombre de la web con un guión o una barra vertical. Podemos ver fácilmente todos los títulos de las páginas con Screaming Frog

Meta Descriptions

Aunque no es un factor de posicionamiento, afecta de manera considerable a la tasa de clicks (click-through rate) en los resultados de búsqueda.

Para la meta description seguiremos los mismos principios que con el título, solo que la longitud de está no debe de exceder los 155 caracteres. Tanto para lo títulos y la descripciones debemos de evitar la duplicidad, esto lo podremos comprobar en Google Webmaster Tools (optimización > mejoras HTML).

Otras elementos HTML

- Meta Keywords – Simplemente elimínalas si existen, Google no las usa para nada

- Etiqueta «rel=canonical» – Si hay alguna página usando esta etiqueta debemos de asegurarnos de que dirija a la página correcta. Cómo usar la etiqueta «rel=canonical»

- Etiquetas «rel=prev ; rel=next» – Si hay páginas usando estás etiquetas, lo mismo, asegurarnos que apuntan hacia las páginas adecuadas. Cómo usar las etiquetas «rel=prev ; rel=next».

- Etiquetas H1, H2, H3…- Debemos de analizar si todas las páginas hacen uso de estas etiquetas y de si en ellas se incluyen keywords relevantes para el contenido.

Imágenes

A la hora de analizar la imágenes debemos de tener en cuenta 3 factores:

- El peso de la imagen – Con esto me refiero a su peso Kb, para ello hay que revisar si están comprimidas, si tienen redimensión, etc. Esta información nos la aportara Google Page Speed

- La etiqueta «alt» – Esta tiene que ser descriptiva con respecto a la imagen y contenido que rodea a la imagen

- Título de la imagen – Lo mismo que en el punto anterior

Enlaces

Es muy importante analizar el numero de enlaces, tanto externos como internos, y a donde están enlazando, para ello (otra vez, que pesado el tío con las listas) haremos una lista con los factores más importantes:

- El número de enlaces por página no debe superar los 100 y todas las páginas deben de tener un numero de enlaces similar

- Los links externos deben apuntar a sitios importantes y relevantes para el contenido de la web

- El anchor text de los enlaces deberá de tener keywords importantes, pero tampoco deberemos usar las mismas keywords para todos los enlaces

- No debe de haber ningún enlace roto ni apuntado a páginas con errores 404

- Puede que haya links que apunten a páginas con redirecciones, si es así, se cambiaría la URL por la página de destino final

- Debe de haber un buen ratio entre enlaces follow y nofollow, no todos deben de ser follow ni todo nofollow

También debes de asegurarte que las páginas importantes reciban links de las otras páginas importantes de la web y de que todas las páginas en la web tengan al menos un enlace apuntando hacia ellas.

¡Por fin!

Siguiendo todos estos pasos haremos un análisis SEO on-site de cualquier web con el que podremos tirarnos horas delante de la pantalla para luego dejarla impecable. Me gusta mucho incidir en que por mucho link-building que sea haga, si esos enlaces apuntan a páginas que nos hagan llorar, no valdrán para nada.